adrianrohnfelder

Moderators

-

Benutzer seit

-

Letzter Besuch

Alle Inhalte von adrianrohnfelder

-

Quick Tipp: Mehrere Versionen mit Permutation automatisch auf einmal generieren lassen

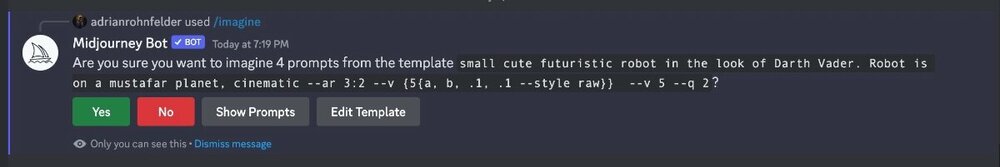

Spätestens mit den Versionen 5.1 bzw. 5.1 --style raw müsste man eigentlich jedes Motiv mit mehreren Versionen generieren lassen, da mal die eine und mal die andere Version ein passenderes Ergebnis liefert. Mit Permutationen kann man das in einen einzigen Prompt packen und automatisieren: Prompt: small cute futuristic robot in the look of Darth Vader. Robot is on a mustafar planet, cinematic --ar 3:2 --v {5{a, b, .1, .1 --style raw}} Midjourney fragt Euch dann ob Ihr wirklich vier Versionen rechnen lassen möchtet. Mit "Yes" bestätigen und los geht es. Grundsätzlich sehr praktisch, allerdings mit dem Wermutstropfen, dass das nur im /fast Modus funktioniert und daher zu Lasten Eurer Rechnerzeit geht.

-

Reproduzierbarkeit von Ergebnissen bei MJ

Wobei das mit dem seed aus meiner Erfahrung auch nur bei ähnlichen Motiven hilft. Ich habe gestern mal mit seed probiert, ein identisches Raumschiff (Urpsrungsfrage hier war ja ein U-Boot) in eine völlig andere Szenerie zu setzen. Mal in eine Wüste, mal in eine Vulkanlandschaft. Das Raumschiff sieht trotz identischer "Raumschiff Prompts" und --seed komplett anders aus.

-

Midjourney 5.1 veröffentlicht

Letzter Test für heute: Drachen. Dieses Motiv ist für mich eine der größten Herausforderungen, die Physiognomie hat bisher so gut wie nie funktioniert. Prompt: dangerous malevolent fire breathing dragon, full body, with glowing eyes and large leathery wings and sharp talons fights against an large army of heavily-armored dwarves in the region of Mordor, flames, debris, scene of desctruction, dramatic light, cinematic lighting v5 v5.1 v5.1 --style raw Also hier hat v5.1 eindeutige Fortschritte gemacht! Auch die Zwergenarmee hat in v5.1 immerhin einmal funktioniert. Wenn jetzt auch noch das Feuer spucken klappen würde 🤪, aber gut, v5.2 und v6 dürfen ja auch noch Raum für Verbesserungen haben 🙂

-

Mandalorian Roboter

Kleiner Roboter im Mandalorian Look 🙂

-

adrianrohnfelder_small_cute_kawaii_futuristic_robot_with_a_mand_6d9356e9-108f-4b7d-afc5-0ff522335f0f.jpg

adrianrohnfelder_small_cute_kawaii_futuristic_robot_with_a_mand_6d9356e9-108f-4b7d-afc5-0ff522335f0f.jpg

-

adrianrohnfelder_small_cute_kawaii_futuristic_robot_with_a_mand_1ac740b9-96e7-4812-a095-7b9a5e8d6680.jpg

adrianrohnfelder_small_cute_kawaii_futuristic_robot_with_a_mand_1ac740b9-96e7-4812-a095-7b9a5e8d6680.jpg

-

adrianrohnfelder_small_cute_futuristic_robot_with_a_mandalorian_ad507331-e79c-4895-b65b-a39d896e5406.jpg

adrianrohnfelder_small_cute_futuristic_robot_with_a_mandalorian_ad507331-e79c-4895-b65b-a39d896e5406.jpg

-

-

Midjourney 5.1 veröffentlicht

Hier noch ein Beispiel, bei dem ich ein KI-Bild als Vorlage genommen und mir als Anime rechnen lassen habe. Prompt: URL_KI_Bild anime, manga, steampunk, young explorer astronaut in yellow suite at a rocky exoplanet where an ufo shaped spaceship is landing: v5 v5.1 v5.1 --style raw Laut Midjourney soll ja v5.1 mehr v4 entsprechen. In diesem Fall finde ich aber, dass v5.1 raw eher den etwas verspielten Style von v4 hat. Zudem scheinen bei v5.1 die Gesichter etwas besser als bei v5 zu sein, wenn auch noch immer nicht perfekt. Und --niji 5 funktioniert noch nicht mit v5.1.

-

Midjourney 5.1 veröffentlicht

Musste ich natürlich gleich einmal ausprobieren 🙂 Prompt: Landscape: Bisti Wilderness badlands during twilight Lighting: Warm hues of setting sun and deepening blue sky Main feature: Cracked egg-like sandstone formations Formation details: Jagged fissures, layers of sandstone, shale, and coal Shadows: Long shadows adding depth and contrast Sky: Gradation from shades of orange and pink to deep blue Mood: Tranquil and otherworldly Stars: Faint appearance of stars in the sky cinematic, photographed with Sony Alpha 1, lens Sony FE 16-35 f2.8 G Master, focal length 15mm, iso 100, F/11 v5 v5.1 -> deutlich bläulicher, woher kommt das Wasser? v5.1 --style raw -> auch Wasser, ansonsten gefühlt eine Mischung aus v5 und v5.1 Prompt: Equirectangular panorama photo of Jökulsárlón glacier lagoon, a landscape of glaciers, icebergs, volcanic rock and black sand beaches, sunset with red glowing clouds, unreal engine 5, cinematic, ultra-wide angle lens, taken from a very low position v5 v5.1 -> auch bläulicher, Bildfehler in Bild2 v5.1 --style raw -> gefühlt wieder eine Mischung Prompt (lang, via Chat GPT): A spaceship is landing in the Bisti Wilderness badlands during sunset with red glowing clouds. Spaceship: The spaceship is a sleek and futuristic vessel inspired by the aesthetics of the movie Tron. Its streamlined, aerodynamic design features a predominantly dark red body with angular surfaces and sharp edges that convey a sense of speed and agility. The spaceship appears to be composed of advanced materials, as its surface has a smooth, polished finish. One of the most striking features of the spaceship is the presence of vibrant, blue glowing lines that run along the contours of its structure. These lines are reminiscent of the iconic light trails from the Tron universe and contribute to the vessel's otherworldly appearance. The lines emit a bright cyan hue, creating a stark contrast against the red body of the spaceship. The spacecraft's design includes a cockpit area, which seems to be integrated seamlessly into the overall form. It is enclosed by a transparent canopy that allows for a clear view of the vessel's interior. The spaceship rests on a set of retractable landing gear, suggesting that it is capable of vertical takeoff and landing. The spaceship is landing in the Bisti Wilderness badlands of which the landscape is characterized by countless rock formations such as hoodoos, rock arches, mushrooms and other peculiar structures. These formations are the result of thousands of years of erosion and come in a variety of colors, including white, gray, brown, orange and even pink. Many of these rock formations resemble animals, objects or mystical creatures, giving the landscape an almost otherworldly atmosphere. The Bisti Wilderness is a barren and arid area without any vegetation. Atmosphere: The choice of setting adds an element of isolation and intrigue, as the juxtaposition of the advanced technology represented by the spaceship and the raw, untamed nature of the Bisti Wilderness Badlands creates a visually striking and thought-provoking image. Sunset: Golden Sunset with red glowing clouds, unreal engine 5, cinematic, photographed with Sony Alpha 1, lens Sony FE 16-35 f2.8 G Master, focal length 15mm, iso 100, F/11 v5 v5.1 v5.1 --style raw Prompt: gigantic mechagozilla on a mustafar like planet, glowing lava, laser beam, sunset storm, nightography, unreal engine 5, cinematic lighting, volumetric lighting, ray tracing global illumination, CGI, VFX, SFX, RTX v5 v5.1 v5.1 --style raw Prompt: an image of a dark red spaceship is landing in a desert in a city showing the tall spire, in the style of michael heizer, michal karcz, matte photo, richard serra, sculpted, The spaceship is a sleek and futuristic vessel inspired by the aesthetics of the movie Tron, neon glowing, fujifilm natura 1600, distressed and weathered surfaces, thunderstorm, lightning bolts, dystopia atmosphere unreal engine 5, cinematic, photographed with Sony Alpha 1, lens Sony FE 16-35 f2.8 G Master, focal length 15mm, iso 100, F/11 v5 v5.1 v5.1 --style raw Erstes Fazit: alle drei Versionen bringen bei identischen Prompts und Parametern jeweils brauchbare, jedoch unterschiedliche Ergebnisse. Da heißt es aus meiner Sicht erst einmal: Ab sofort alle Motive in drei verschiedenen Versionen rechnen lassen und ein Hoch auf den /relax Modus 😉 Habt Ihr schon probiert?

-

Quick Tipp: Panorama mit Midjourney

Ja, sehr spannend, bin über dieses Video (auf Englisch) hier drauf gestoßen:

-

Reproduzierbarkeit von Ergebnissen bei MJ

Ich war damit auch nur bescheiden erfolgreich, wollte das die Tage aber noch einmal intensiv ausprobieren. Praktischerweise geht das mit der Anzeige der Seed Nummer "per Briefumschlag" nun endlich auch in v5.

-

Reproduzierbarkeit von Ergebnissen bei MJ

Gute Frage, nächste Frage 🙂 Im Ernst, das ist in der Tat eine DER Herausforderungen mit Midjourney. Ich habe dazu auch bereits einen Artikel in Vorbereitung, bin aber auch noch am probieren. Ich habe es versucht mit jeder Art von Prompt, Parameter und Befehlen: /blend, Fotos als Vorlage, KI-Motiv (in Deinem Fall die Vorlage für das U-Boot) als Vorlage, /describe, Bildbeschreibung via Chat GPT, /remix ohne Erfolg. Bei mir ist es ein Raumschiff, welches ich auf unterschiedlichen Planeten landen lassen möchte. Ab und an ähnlich ja, eindeutig erkennbar nein. Bei Personen funktioniert es einigermaßen wenn man bekannte Personen als Vorlage nimmt weil MJ da auf viele Trainingsdaten zugreifen kannst. Was Du basierend darauf probieren könntest ist ein reales bekanntes U-Boot zu finden von dem es viele Bilder im Web gibt und das mit in Deine Prompts aufnimmst. Oder dem U-Boot eine ganz einfache Form gibst, zumindest werde ich das als nächstes mit "meinem" Raumschiff probieren. Ein einfaches Raumschiff in Form eines silbernen langen Tropfens - auf die Idee bin ich gekommen, weil mir MJ neulich zufällig so ein Raumschiff generiert hat - o.k., es sollte grds. eigentlich rot sein und eine völlig andere Form haben 🙈 Oder alternativ mit Stable Diffusion arbeitest, da kann man sich Modelle bauen und die weiter nutzen. Ist aber deutlich aufwendiger und habe ich selbst auch noch nicht gemacht. Alle Raumschiffe gleich beschrieben 🤪:

-

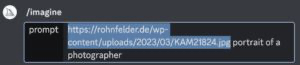

Midjourney Parameter image weight (--iw)

In Midjourney könnt Ihr eigene Fotos und Bilder als Vorlage nutzen. Mit dem Parameter --iw (image weight) könnt Ihr am Ende Eures Prompts eine Gewichtung mitgeben, wie stark sich Midjourney am originalen Foto orientieren soll. Dabei sind in der Version 5 Werte zwischen 0.5 und 2 möglich, Standard ist 1. Als Beispiel habe ich ein Foto von mir aus der Karakum Wüste in Turkmenistan genommen. Innerhalb des /imagine Befehls habe ich zuerst die externe URL zu dem Bild angegeben und dann den Prompt young photographer neon glowing: Originalfoto --iw 2 --iw .5 Auf diese Art könnt Ihr z.B. versuchen, aus Euch selbst eine Comicfigur o.ä. zu generieren. young photographer 3d rendering in pixar style--iw 2 Ein separater Thead zu dem Thema Avatar folgt...

-

Quick Tipp: Panorama mit Midjourney

Übrigens, ich habe zu dem Thema Midjourney und 360 Grad noch die Prompts seamless 360, spherical panorama, perfectly aligned horizon gefunden aber noch nicht ausprobiert. Vielleicht jemand von Euch?

-

Quick Tipp: Panorama mit Midjourney

Da wird man glaube ich nie vollständig hinterher kommen, viele Dinge entdecke ich auch nur hier und da per Zufall. Neulich habe ich noch irgendwas von Mathematik und Midjourney gelesen. Aber wir arbeiten ja dran, hier so viel wie möglich abzudecken 😉

-

Quick Tipp: Panorama mit Midjourney

Ich experimentiere gerade ein wenig mit Panoramen in Midjourney. Am Ende möchte ich mich auch einmal an einem 360 Grad Panorama mit einer separaten Panorama- bzw. VR-App versuchen, aber es taugt aus meiner Sicht auch schon so für schöne extrem weinwinklige Bilder. Ich nutze dazu den Prompt Equirectangular panorama photo of und ergänze am Ende des Prompts noch ultra-wide angle lens sowie den Parameter --ar 16:9. Habt Ihr so etwas schon probiert oder kennt andere Befehle und Möglichkeiten?

-

Geld verdienen mit Midjourney & Co.

Das ist alleine schon die Frage womit man die Abo Preise von Midjourney refinanzieren kann 🙂 Eine Idee wäre es, die Bilder direkt zu verkaufen. Als Print, als NFC (zumindest wurde ich da schon zwei Mal entsprechend angefragt), als Oster-, Weihnachts-, Geburtstagspostkarte. KI generierte bzw. unterstützte Geschichten mit KI generierten Bildern als e-Books verkaufen. KnowHow in Form von Prompt-Sheets, Workshops, Tutorials etc. hast Du ja schon angesprochen. Prompt Engineering an sich wird wohl ein eigener Berufszweig. Aber warum beantworte eigentlich ich die Frage, das kann doch Chat GPT 4 sicher viel besser 😉 Stockfoto-Websites: Laden Sie KI-generierte Bilder auf Stockfoto-Websites hoch und verdienen Sie Geld, indem Sie Lizenzen für die Verwendung Ihrer Bilder verkaufen. Beispielsweise können Shutterstock, Adobe Stock und iStock genutzt werden. Kunst und Design: Erstellen Sie einzigartige KI-generierte Kunstwerke und verkaufen Sie diese als physische oder digitale Prints, Poster oder auf Leinwand. Sie können auch KI-generierte Designs für Produkte wie T-Shirts, Tassen, Handyhüllen usw. erstellen und diese über Plattformen wie Redbubble, Society6 oder Teespring anbieten. NFT-Marktplätze: KI-generierte Bilder können als Non-Fungible Tokens (NFTs) auf Blockchain-Marktplätzen wie OpenSea, Rarible oder Foundation verkauft werden. NFTs sind digitale Sammlerstücke, die einzigartig und nachverfolgbar sind und so Wert für Käufer schaffen. Marketing und Werbung: Bieten Sie Ihre Dienste als KI-generierter Bilder-Designer für Marketing- und Werbematerialien an. Unternehmen suchen oft nach kreativen und ansprechenden Visuals für ihre Marketingkampagnen. Lizenzen: Verkaufen Sie Lizenzen für Ihre KI-generierten Bilder an Unternehmen, die sie in ihren Produkten oder Dienstleistungen verwenden möchten, z. B. für Computerspiele, Apps oder digitale Medien. Online-Kurse und Tutorials: Teilen Sie Ihr Wissen über das Erstellen von KI-generierten Bildern, indem Sie Online-Kurse, Tutorials oder Workshops anbieten und dafür eine Gebühr erheben. KI-Tools und Software: Entwickeln Sie eigene KI-Tools oder Software zum Generieren von Bildern und verkaufen Sie diese als Service oder Produkt. Bildbearbeitungsdienste: Bieten Sie KI-gestützte Bildbearbeitungsdienste an, um Fotos zu optimieren oder zu verändern. Dazu gehören beispielsweise Hintergrundentfernung, Stiltransfer oder Farbkorrektur. Partnerschaften: Arbeiten Sie mit Künstlern, Designern oder Unternehmen zusammen, um KI-generierte Bilder zu erstellen und diese gemeinsam zu vermarkten oder zu verkaufen. Patreon oder Abonnement-Modelle: Bieten Sie regelmäßige KI-generierte Inhalte wie Bilder, Hintergrundbilder oder exklusive Kunstwerke auf einer Abonnementbasis an, z. B. über Patreon oder andere Abonnement-Plattformen. Jetzt muss Chat GPT das nur noch automatisch und selbständig für uns umsetzen, Stichwort AutoGPT 🙂

-

Monetarisierungsideen für die --tile Funktion

Sehe ich auch so, allerdings nicht auf die Profis reduziert. Wenn ich so sehe was alles an bezahlten Fotokursen funktioniert trotz YouTube und einfachsten Erklärungen im Web, dann glaube ich am ehesten auch an das Thema Fortbildung. Mit dem Vorteil ggü Fotokursen, dass es in dem Bereich in der nächsten Zeit permanent etwas neues und recht krasse Entwicklungen geben wird, welche immer wieder neuen Bedarf schaffen werden. Auf der anderen Seite, wer kann bei dem Thema schon einschätzen wie die Welt in ein paar Monaten aussehen und ticken wird...

-

Monetarisierungsideen für die --tile Funktion

Naja, das war mehr als Info gedacht weil immer irgendeiner fragt 🙂

-

Monetarisierungsideen für die --tile Funktion

Dafür braucht es aber v5 bzw. v3 und früher, oder? Ich meine in v4 gibt es --tile nicht?

-

Animierte Bilder und Videos mit Kaiber.AI

Hehe, und jeden Tag poppt was neues auf, da würden selbst 24 Stunden nicht reichen für die Menge an Spielmöglichkeiten 🙂

-

StableLM ernsthafter potentieller Konkurrent von Chat GPT?

Die Firma hinter der Bild-KI Stable Diffusion hat nun auch eine Open Source Text KI, StableLM veröffentlicht. Diese wird von manchen Experten bereits als ernsthafte potentielle Konkurrenz zu Chat GPT der Firma OpenAI gesehen.

-

Midjourney Parameter "--stop"

Midjourney v5 ist was Fotorealismus angeht aus meiner Sicht aktuell der unangefochtene Primus unter den Bildgeneratoren. Allerdings ist damit auch ein wenig der künstliche und verspielte Charme der Version 4 verloren gegangen. Mit welchen Prompts man diesen mehr oder weniger auch in Version 5 erreichen kann zeige ich Euch hier. Zufällig habe ich heute dazu noch den Parameter --stop entdeckt bzw. erstmalig ausprobiert. Damit könnt Ihr Midjourney mitgeben, dass die Bildgenerierung vorzeitig beendet wird. Das Bild wird also nicht zu 100% generiert, sondern nur bis zu dem via --stop mitgegebenem Prozentsatz, was zu einem nicht perfekten und somit wieder mehr verspieltem Look führt. Prompt: burning scifi spaceship is floating through space, dystopia --ar 3:2 ohne --stop --stop 75 --stop 50 Sehr spannend ist diese Möglichkeit auch bei der Variante --niji, Prompt: anime, manga, spaceship battle --ar 3:2 ohne --stop --stop 75 --stop 50

-

Animierte Bilder und Videos mit Kaiber.AI

Ja, Du kannst auch deutlich längere Videos machen, in einer bezahlten Variante meine ich sogar richtig lange. Es können wohl auch Videos als Basis genommen werden, sah auf den ersten Bild wirklich spannend und ganz vielversprechend aus.

-

Ausführliches und übersichtliches deutsches Midjourney Tutorial und FAQ

Midjourney ist ein Programm welches auf künstlicher Intelligenz basiert und auf Basis von Text-Eingaben, sogenannten Prompts Bilder (text to image) erzeugt. Diese Bilder werden völlig neu generiert (erstellt, errechnet) und nicht aus anderen Bildern zusammenkopiert. Midjourney ist kein Bildbearbeitungsprogramm. Installation und erste Schritte: Die Installation erfolgt über die kostenlose Kommunikationsplattform Discord, eine eigenständige App ist jedoch in Planung. Bilder werden über den Befehl /imagine gefolgt von dem Prompt und eventuellen Parametern beauftragt. Installation und Bilderstellung sind einfacher, als es auf den ersten Blick erscheint. Preise und Abos: Derzeit gibt es keinen kostenlosen Testaccount mehr, sondern nur noch vier unterschiedliche Abonnements. Ultimative Prompt Tipps: Wer es übrigens nicht abwarten kann bis zum Ende zu lesen, der findet auch hier schon einmal den Link zu den ultimativen Prompt Tipps 😉 Midjourney Parameter: --ar → aspect ratio definiert das Seitenverhältnis wie 3:2, 16:9, 2:3 (ab v5 sind alle Werte möglich) --c → chaos definiert wie sehr das Bildergebnis variiert (Werte von 0 - 100, Standard 0) --q → quality definiert wie detailreich (die Auflösung bleibt gleich!) ein Bild wird. Je höher der Wert ist, desto mehr Rechenzeit wird verbraucht (Werte von 0.25 - 2, Standard 1) --s → stylize definiert wie sehr der Midjourney interne ästhetische Stil angewandt wird. Dieser Stil ist von Version zu Version unterschiedlich. In den /settings kann dieser Wert als low, med, high, very high generell gesetzt oder als Parameter einem Prompt mitgegeben werden (Werte von 0 - 1000, Standard 100) --no → schließt Prompts aus, ein --no plants wird versuchen, dass keine Pflanzen im Bild zu sehen sein werden --r → repeat gibt an, dass ein Job mehrfach generiert wird, --r 3 ergibt drei 4er Variationen (Werte von 1 - 40, Standard 1), funktioniert nur im /fast Modus --seed → Der Midjourney-Bot verwendet eine sogenannte seed Nummer (eine Art Grundrauschen) als Ausgangspunkt für die Erzeugung der Bilder. Die seed Nummer wird für jedes Bild zufällig vergeben. Sie kann nach der Generierung ausgelesen und einem weiteren Auftrag mitgegeben werden, was zu ähnlichen Ergebnissen führt. --stop → beendet die Bildgenerierung zu dem vorgegebenen Prozentwert. Dies führt zu unschärferen, weniger detaillierten und damit künstlerischer angehauchten Ergebnissen (Werte von 0 - 100, Standard 100) --tile → erzeugt Bilder, welche als sich wiederholende Kacheln verwendet werden können, um nahtlose Muster zu erstellen --v → version gibt an, welche Version für das aktuelle Bild genutzt werden soll. Die Version kann in den /settings grundlegend eingestellt wie auch als Parameter einem Prompt mitgegeben werden. Aktuell ist die Version 5.1, insgesamt sind derzeit wählbar: v1, v2, v3, v4, v5, v5a, v5b und v5.1 --style → von den Versionen 4 sowie 5.1 gibt es noch Varianten in der Form von unterschiedlichen Stilen wie --style 4a, --style 4b, --style 4c für die Version 4 und --style raw für die Version 5.1. Letztgenannter wird z.B. über --v 5.1 --style raw gewählt. Zudem gibt es noch unterschiedliche Stile für die niji-Modelle (siehe nächster Punkt) --niji / --niji 5 → “Niji” (ausgesprochen nee-gee) bedeutet auf Japanisch Regenbogen. Es ist spezieller, experimenteller Midjourney-Algorithmus für deutliche verbesserte Anime-Stile und -Bilder. Er ist ein separater, eigenständiger Algorithmus welchen man in den /settings ein- bzw. ausschalten kann oder auch als --niji Parameter einem Prompt mitgeben kann. Für den Modus --niji 5 können zusätzlich noch die Stile (siehe vorheriger Punkt) --style cute, expressive oder scenic mitgegeben werden --iw → image weight gewichtet wie sehr sich Midjourney an einem eigenem, als Vorlage verwendetem Bild/ Foto orientiert (Werte von 0.5 - 2, Standard 1) (siehe dazu auch den Punkt “Eigene Bilder” unter Fortgeschritten) --video → erstellt ein Video der Bildgenerierung --weird → macht die Ergebnisse merkwürdig. Einfach ausprobieren, in bestimmten Fällen kommt man damit warum auch immer zu einem gewünschten Ergebnis. Midjourney Befehle: /blend → damit können bis zu 5 eigene Bilder gemischt, jedoch keine zusätzlichen Prompts mitgegeben werden (wie das funktioniert ist unter dem Punkt “Eigene Bilder” unter Fortgeschritten erklärt) /describe → beschreibt ein hochzuladendes Foto/ Bild in der Form von Prompts. Es werden vier Alternativen angeboten, welche sich dann auch gleich wieder separat generieren und/oder verändern lassen /fast /relax → der fast-Modus generiert die Bilder schnell, wird jedoch auf die kostenpflichtige Rechnerzeit angerechnet. Im relax-Modus (ab dem Standardplan verfügbar) kann die Generierung bis zu 10 Minuten dauern, wird aber nicht auf diese Rechnerzeit angerechnet /info → zeigt die Anzahl der bisherigen Jobs, die verwendete sowie verbleibende Rechnerzeit, das genutzte Abo und weitere Informationen rund um den Account an /settings → zeigt die gewählten, grundsätzlich geltenden Grundeinstellungen des eigenen Midjourney Bots an: Version, Niji-Mode, Stylize Wert, Public-, Fast-, Remix-Mode. Diese Einstellungen können mit jedem Prompt per Parameter aber auch als anderer Wert mitgegeben werden /public /stealth → schaltet zwischen öffentlichem und privatem Modus (ab dem Pro Plan) hin und her /prefer option → Erstellt einen benutzerdefinierten Parameter, mit dem mehrere Prompts sowie Parameter auf einmal an das Ende einer Eingabeaufforderungen angefügt werden können. Dieser wird mit /prefer option set <name des eigenen parameters> <inhalt des eigenen parameters> gebildet /prefer option list → zeigt die benutzerdefinierten Parameter an /prefer suffix → ermöglicht die Mitgabe von mehreren Parametern analog zu /prefer option, erlaubt dabei jedoch nur Parameter und keine Prompts /remix → schaltet den Remix-Modus ein. Damit kann ein Prompt im Rahmen eines Upscalings noch einmal verändert werden /shorten → analysiert Euren Prompt und zeigt an, welche Token (quasi Wörter) mit welcher Gewichtung eine Berücksichtigung finden /tune -> der ab v5.2 nutzbare Style Tuner mit dem man seine ganz eigenen visuellen Styles generieren und auf Bilder anwenden kann Fortgeschrittene Befehle: Eigene Bilder: Midjourney bietet die Möglichkeit, eigene Bilder als Vorlage über die Mitgabe der Bild-URL in einem Prompt als Basis für die Bildgenerierung zu verwenden Multi Prompt: Ein :: nach einem Prompt teilt Midjourney mit, dass dieser Part des Prompts als eigenständiger Text behandelt werden soll: dog biscuit ergibt einen Hundekuchen, dog:: biscuit einen Hund und einen Kuchen Prompt Weight: Mit einem :: und einer zusätzlichen Ziffer können einzelne Prompts gewichtet werden. Dabei können auch negative Ziffern (die Wirkung ist dann analog zu dem --no Parameter) verwendet werden, in Summe müssen die Ziffern jedoch einen positiven Wert ergeben Permutation: Erlaubt die schnelle Generierung von Variationen eines Prompts mit einem einzigen /imagine Befehl (funktioniert nur im /fast Modus). Ein a {red, green, yellow} bird Prompt ergibt drei Jobs, also jeweils vier Variationen eines roten, eines grünen sowie eines gelben Vogels Zoom Out: Mit dem Zoom Out oder auch Outpainting genannt können Bilder am Rand (inhaltlich, nicht von der Auflösung her) erweitert werden. Pan: Mit dem Panning können Bilder in eine Richtung (inhaltlich wie auch von der Auflösung her) erweitert werden. Vary (Region): Mit dem sogenannten Inpainting können Bereiche innerhalb eines Bildes verändert werden. InsightFaceSwap: Ein generiertes Gesicht durch ein Foto-Portrait austauschen. Pro Tipps: Eigenen Discord Server erstellen 8 (ultimative) Prompt Tipps Sinnvoller Promptaufbau Konsistente Bilder Panorama Doppelbelichtung Emoji Prompts Kameraperspektiven ...weitere folgen

-

Was ist Midjourney - und was nicht

Nachdem ich öfters gefragt werde, wie man eigene Bilder mit Midjourney bearbeiten kann, beschreibe ich hier einmal ganz kurz und knackig was Midjourney kann und was (noch) nicht: Midjourney ist: Ein Bildgenerator, mit dem ich via Prompts (Texte) ein Bild beschreiben und generieren lassen kann (generieren heißt dabei, es wird komplett neu erstellt und nicht aus irgendwelchen Vorlagen aus dem Internet etc. kopiert). Mit den Prompts können Bilder sehr detailliert beschrieben werden. Trotzdem hat man damit nur eine bedingte Kontrolle über das Ergebnis. Ähnliche Prompts oder eine andere Reihenfolge der identischen Prompts kann ein völlig anderes Bildergebnis bringen. Und Serienbilder, also z.B. Bilder von der gleichen Person in unterschiedlichen Situationen sind nur sehr sehr sehr eingeschränkt bis eigentlich überhaupt nicht möglich. Zusammengefasst entstehen also komplett neue Bilder in einer gewissen Streubreite um die Prompts herum. Midjourney ist nicht: Midjourney ist keine Software zur Bildbearbeitung. Es ist nicht möglich, eigene Fotos zu bearbeiten bzw. Teile eines Fotos um ein KI generiertes Motiv zu ergänzen. Es ist möglich, eigene Bilder als Vorlage für neu zu generierende Bilder zu verwenden, aber mit allen Einschränkungen der o.g. Streubreite und bedingten Kontrolle.

-

Eigene Bilder als Vorlage in Midjourney nutzen

Besonders spannend finde ich die Möglichkeit, Midjourney eigene Fotos (oder auch KI generierte Bilder) als Vorlage mitzugeben. Dadurch kann man zum einen den Stil und das Aussehen eines zu generierenden Bildes ziemlich genau vorgeben. Zum anderen können so auf Basis eigener Fotos und Erlebnisse sehr spannende Welten, Geschichten, Avatare und so umgesetzt werden. Die erste Möglichkeit dafür ist, Bilder direkt bei Discord hochzuladen und diese dann in den Prompt zu integrieren – was bei allerdings warum auch immer nicht klappt. Genauso einfach ist aber auch die Variante, eine externe URL zu dem Bild zu verwenden. Gebt dazu diese URL als ersten Prompt direkt nach dem Befehl /imagine ein, also /imagine http://bildURL.jpg und danach die gewünschten Motivprompts und Parameter zur Bildbeschreibung eingeben. Ist wirklich nicht kompliziert, noch verständlicher wird es aber sicher mit ein paar Bildbeispielen, u.a. auch dazu, dass mit –iw (image weight, Werte zwischen 0.5 und 2) Midjourney noch mitgegeben werden kann, wie sehr es sich am Original orientieren soll: (achja, Ihr könnt übrigens auch zwei URL einfügen und so Bilder mischen, dazu folgt demnächst ein eigener Post) Originalfoto aus der Namib Wüste Bild-URL mit den Prompts (das originale Foto beschrieben): namibia, sossusvlei, deadvlei Bild-URL mit den Prompts: cookie monster playing the guitar Bild-URL mit den Prompts: scifi ring portal Bild-URL mit den Prompts: stormtrooper, full body

-

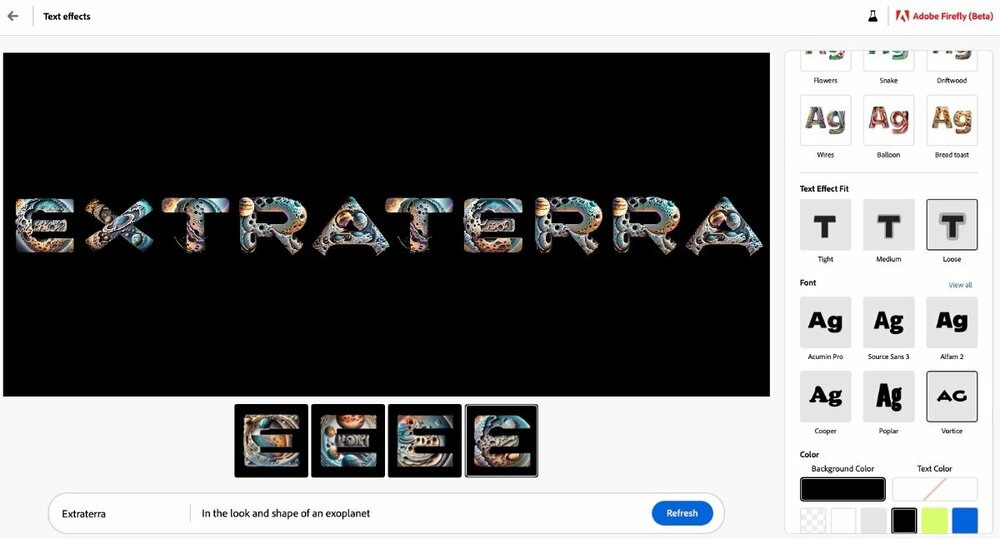

Adobe Firefly: Text Effekte

Der große Unterschied von Adobe Firefly zu z.B. Midjourney ist, dass man damit Text gestalten kann. Man kann in Firefly einen kurzen Text eingeben und mit einer Textur etc. versehen lassen, allerdings nicht mit einem Bild kombinieren - das müsste man derzeit noch händisch in Photoshop oder so erledigen. Die Vorgehensweise ist sehr einfach. Text eingeben, vorgefertigten Stil wählen oder per Prompt beschreiben, Font und Hintergrundfarbe wählen, et voila. Die grds. jeweilige Auswahl ist noch nicht wirklich groß, zeigt aber schon einmal gut die Richtung.

_055d65.png)

_ee1da0.png)