Lange Prompts, kryptische Formulierungen und viel Trial & Error – all das könnte bald vorbei sein. Denn eine neue Technik hebt das KI-Video-Prompting auf ein völlig neues Level: Statt alles umständlich zu beschreiben, malt und schreibt Ihr Eure gewünschte Animation einfach direkt in das Startbild.

Der Workflow ist ganz einfach:

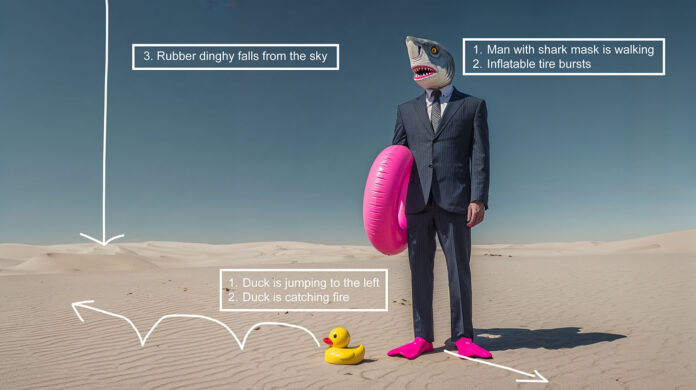

- Ausgangsbild (z.B. mit Midjourney wie in unserem Fall) generieren.

- In Photoshop oder einer Alternative Pfeile und textliche Anweisungen in das Ausgangsbild malen.

- Bearbeitetes Bild in das KI-Videotool laden und die Videogenerierung ohne Prompt starten.

Getestet haben wir das mit MiniMax Hailuo 02, das funktioniert aber auch mit Google Veo 3 und Wan 2.2.

Diese Tools sind in der Lage, Eure Anweisung zu „lesen“ und zu „verstehen“, was häufig richtig gut funktioniert. Teilweise besser und präziser als mit einem klassischen Textprompt.

Doch natürlich gibt es auch hier noch Grenzen:

Wiederholbarkeit: Ein identisches Ausgangsbild kann zu völlig unterschiedlichen Videos führen.

Begrenzte Interpretation: Nicht jede gezeichnete Anweisung wird umgesetzt.

Objekterkennung: Die gezeichneten Elemente sollten klar erkennbar sein.

Komplexität: Je komplexer die gewünschte Bewegung, desto fehleranfälliger die Umsetzung

Nichtsdestotrotz ist das ein faszinierender und insbesondere einfacher Ansatz, der besonders visuell denkenden Kreativen entgegenkommt. Statt mühsam zu prompten, lässt sich nun direkt zeichnen, was man in einem Video sehen möchte. Und das ist oft intuitiver als jede Formulierung. Auch wenn noch nicht alles funktioniert: Der Weg vom Bild zur Bewegung wird kürzer – und direkter.