Andreas J.

Administrators

-

Benutzer seit

-

Letzter Besuch

Alle Inhalte von Andreas J.

-

Midjourney testet Moderation durch Künstliche Intelligenz

Update: Der Test ist für heute (26. April 2023) abgeschlossen, nächste Woche soll der Test fortgesetzt werden

-

Midjourney testet Moderation durch Künstliche Intelligenz

Midjourney hat heute morgen angekündigt, für einen kurzen Zeitraum das System der „gesperrten Begriffe“ durch einen KI Moderator zu ersetzen. Das neue System soll mehr Kontext verstehen und dadurch auch unverfängliche Prompts durchlassen, die das alte System durch stumpfes Anwenden der Blockliste aussortiert hätte. Das Verfahren sieht jetzt so aus: Ein auf Schnelligkeit optimierter AI Prozess scannt den Prompt. Wenn er einen Prompt sperrt, gibt es jetzt die Option „[I would like to appeal]“ („Ich erhebe Einspruch“) Dann springt eine mächtigere (und ressourcenfressende) KI ein und überprüft die Entscheidung. Midjourney verspricht sich von dem System weniger Fehlentscheidungen. » Ankündigung im Midjourney Discord Channel: Deutsche Übersetzung: Hallo wir werden einen kurzen (4 bis 24 Stunden) Test eines neuen KI Moderator Systems (nur für V5) machen. Was bringt das? Dieser neue KI-Moderator ersetzt unser altes System, das auf "gesperrten Begriffen" basiert. Das neue System versteht Prompts im Kontext und sollte viel intelligenter und differenziert sein. Es sollte (hoffentlich) alle unverfänglichen Prompts durchlassen, die das alte System verworfen hat. Wie funktioniert es? Im ersten Schritt verwenden wir eine schnelle KI, um alle Prompts zu scannen. Wenn sie "nein" sagt, haben Sie die Möglichkeit, auf ein [I would like to appeal] („Ich möchte Widerspruch einlegen“) Schaltfläche zu klicken, und die Anfrage wird an eine größere, intelligentere und leistungsfähigere KI weitergeleitet. Die große KI ist ziemlich teuer, daher beschränken wir die Anzahl der Einsprüche vorerst auf 5 pro 24 Stunden. Wir werden diese Zahl dynamisch anpassen, je nachdem, wie viel Traffic entsteht (hoffentlich auf das höchstmögliche Maß). Wir hoffen, dass dieses zweistufige System den Leuten eine fast 100%ige Chance gibt, unschuldige Aufforderungen durchzubekommen. Wozu wir Ihre Hilfe brauchen Unser Hauptaugenmerk bei diesem Test liegt darauf, sicherzustellen, dass unser KI-Moderator keine obskuren Grenzfälle bearbeitet, die große Bereiche des Prompt-Raums blockieren, die nicht blockiert werden sollten. Dieser Test ist keine Ausrede, um unangemessene Bilder zu erzeugen. Das Ziel ist, dass dieses Update für jeden einfach "unsichtbar" sein sollte. Wenn Sie feststellen, dass das System etwas Schlechtes macht, lassen Sie es uns bitte wissen, indem Sie auf [Notify the developers of a incorrect decision] („Benachrichtigen Sie die Entwickler über eine falsche Entscheidung“) nach einem gescheiterten Einspruchsverfahren, oder sprecht uns an über ai-moderation.

-

Vorstellungs-Thread

Um den Thread anzuwärmen, mache ich den Anfang: Hi – mein Name ist Andreas! Baujahr 1966, eigentlich Fischkopf, aber nach 35 Jahren im Rheinland erfolgreich assimiliert. Lebe mit meiner Familie in Bonn und betreibe hauptberuflich Diskussionsforen über Fotografie... Bei KI-Bildern habe ich Blut geleckt – was bei mir automatisch den Impuls auslöst: Dafür braucht die Welt auch ein Forum! So – jetzt haben wir den Salat 😉 Freue mich darauf, euch kennenzulernen! Andreas

-

Vorstellungs-Thread

Neu im Forum? Sind wir zur Zeit alle noch! Mein Vorschlag: Jeder stellt sich einmal kurz vor, damit wir uns kennenlernen!

-

Monetarisierungsideen für die --tile Funktion

Mein Instinkt sagt mir, dass die Preise für nahezu alles, was sich mit Midjourney & Co. machen lässt, ziemlich schnell gegen Null gehen werden. Es wird immer jemanden geben, der es versucht, noch billiger zu machen. Potential sehe ich bei Fortbildung & Tutorials und allem, was Profis die Arbeit dauerhaft leichter macht. Aber da kann ich mich auch komplett irren… Gruß Andreas PS.: Vielleicht sollten wir generell einen Thread oder ein Unterforum einrichten „Geld verdienen mit KI Bildern“…

-

Tipp: Adobe Firefly Beta „Zugangsanforderung“ E-Mail Adresse

Halleluja – ich bin drin! Wochenende ist geblockt…

-

Feedback zum AI Imagelab

Hi @matthew – und willkommen! Danke für das Feedback, ich habe die Schriftdarstellung (Font und Größe) wie im Fuji X Forum eingestellt. Kann sein, dass es noch kurz dauert, bis es anders dargestellt wird. Gruß Andreas

-

Midjourney: Kein kostenloser Testaccount mehr?

Hast du das kürzlich nochmal ausprobiert? Immer noch keine kostenlosen Testaccounts mehr? Gruß Andreas

-

Feedback zum AI Imagelab

Gute Idee, vielleicht auch ein Thread, der alle empfehlenswerten Topics, Galerien oder was auch immer enthält.

-

Feedback zum AI Imagelab

Themen sind Diskussionen, in denen es neue Beiträge gab Beiträge sind einzelne neue Beiträge

-

Was kostet Midjourney?

Was kostet Midjourney? Midjourney hat neben einer kostenlosen Testversion drei verschiedene Abo-Stufen, die sich vor allem durch das Zeitkontingent für die Bildgenerierung unterscheiden. Die Abo-Stufen (auf alle Preise kommen noch 19% Mwst. drauf.): UPDATE: die kostenlose Testversion gibt es leider nicht mehr, maximal nur für kurze Zeit im Rahmen eines Updates bei Midjourney. Die kostenlose Testversion von Midjourney bietet nur einmalig 24 Minuten Rechenzeit an, sobald diese aufgebraucht sind, kannst du keine weiteren Bilder generieren. Mit dem Basic Plan (10$ / Monat oder 96$ pro Jahr) bekommst du 3,3h schnelle Rechenzeit pro Monat. Der Standardplan (30$ / Monat oder 288$ pro Jahr) hat 15h schnelle Rechenzeit, vor allem aber unbegrenzte Kapazitäten für Aufträge im Relax-Modus. Im teuersten Pro Plan (60$ / Monat oder 576$ pro Jahr) sind es 30h Fast GPU Zeit. In dieser Abo-Stufe kann man auch 12 Aufträge parallel bearbeiten lassen. UPDATE: Mittlerweile wurde noch der Mega Plan (120$ / Monat) eingeführt mit 60h Fast GPU-Zeit. Sollten diese Zeiten nicht ausreichen, kann zusätzliche Zeit für $4 pro Stunde nachgebucht werden. Die Abos können entweder monatlich oder für ein Jahr bezahlt werden. Mit der jährlichen Zahlung erhält man 20% Rabatt. Die Bezahlung erfolgt über Stripe, einen Zahlungsdienstleister, der Zahlungen per Kreditkarte (Visa, Mastercard und American Express) abwickelt. Paypal und Banküberweisung werden nicht angeboten, dafür aber Apple Pay. (Stand März 2023) Auf der Midjourney Website findest du auf englisch eine komplette Aufstellung der Abostufen und Zahlungspläne.

-

Was ist bei Midjourney der Unterschied zwischen Fast und Relax Modus?

Was ist der Unterschied zwischen Fast und Relax Modus? Midjourney verwendet leistungsstarke Grafikprozessoren (GPUs), um eure Eingaben zu interpretieren und zu verarbeiten. Wenn du ein Abonnement für Midjourney erwirbst, kaufst du Zeit auf diesen GPUs. Verschiedene Abo-Stufen haben unterschiedliche Mengen an GPU-Zeit pro Monat. Diese monatliche GPU-Zeit im Abo ist die Fast Mode-Zeit: Der Fast Mode versucht, Dir sofort und mit höchster Priorität eine GPU zur Verfügung zu stellen. Im Relax Mode kommen deine Aufträge in eine Warteschlange und werden mit geringerer Priorität abgearbeitet. Dieser Modus steht nur im Standard- und Pro-Modus zur Verfügung. Wie viele GPU-Minuten kosten meine Generationen? Ein durchschnittlicher Auftrag, den der Midjourney-Bot verarbeitet, benötigt ca. eine Minute GPU-Zeit, um ein Bild zu erstellen. Das Hochskalieren eines Bildes oder die Verwendung ungewöhnlicher Seitenverhältnisse kann mehr Zeit in Anspruch nehmen. Das Erstellen von Variationen oder die Verwendung von niedrigeren Qualitätswerten wird weniger Zeit in Anspruch nehmen. Schnellmodus vs. Relax-Modus Wenn du bei Midjourney einen Standard- und Pro-Tarif gebucht hast, kannst du jeden Monat eine unbegrenzte Anzahl von Bildern im Relax-Modus erstellen. Dieser Modus kostet keine GPU-Zeit, aber die Aufträge kommen in eine Warteschlange. Wie schnell dein Auftrag abgearbeitet wird, hängt davon ab, wie oft du das System genutzt hast. Wie lange muss ich im Relax-Modus warten? Aufträge im Relax-Modus warten darauf, dass GPUs verfügbar werden. Die Wartezeiten im Relax-Modus sind sehr unterschiedlich, liegen aber im Allgemeinen zwischen 0 und 10 Minuten pro Auftrag. Wenn Du den Relax-Modus nur gelegentlich nutzt, sind die Wartezeiten kürzer als bei anderen, die ihn häufiger nutzen. Wie wechsele ich zwischen Relax- und Fast-Modus? Du hast verschiedene Möglichkeiten zwischen den beiden Modi zu wechseln: Durch direkte Eingabe von /relax oder /fast Über deine Einstellungen, mit dem Befehl /settings

-

Gibt es eine deutsche Anleitung für Midjourney?

Im Netz gibt es zahlreiche Tutorials und Anleitungen zu Midjourney, von den ersten Schritten bis hin zu detaillierten Anleitungen für Einstellungen und Prompts. Wenn du Midjourney Anfänger bist, empfehlen wir dir das deutsche Midjourney Tutorial hier im Forum, das Adrian noch weiter ausbauen wird. … wie du dich auf der Midjourney Seite registrierst … einen Discord Account anlegst … deine ersten Bilder generierst und … wo du deine Bilder nachher findest Midjourney bietet selber einen gut gepflegten Bereich mit Anleitungen und Informationen, allerdings nur auf englisch.

-

Welche Befehle kann ich in Midjourney benutzen?

Du kannst mit Midjourney über Discord kommunizieren, indem du Befehle eingibst. Befehle werden z.B. verwendet, um… Bilder zu erstellen (Wichtigster Befehl überhaupt ist „/imagine“) Standardeinstellungen zu ändern („/settings“) Hilfestellungen zu bekommen und dein Konto zu bearbeiten. Wenn du noch nicht weißt, wie du Midjourney benutzt, hilft dir Adrians Anleitung „Erste Schritte mit Midjourney und Discord“ weiter. Die wichtigsten Befehle: Bilder generieren /imagine Der wichtigste Befehl, der aus einer Eingabeaufforderung („Prompt“) ein Bild generiert. /blend Mit diesem Befehlt kannst du aus bis zu fünf Bildern ein neues erstellen. Einstellungen /settings Einstellungen des Midjourney Bots anzeigen und anpassen /prefer remix Schaltet den Remix-Modus um. /prefer option Erstellen oder Verwalten einer eigenen Option. /prefer option list Zeige deine aktuellen Optionen an. /prefer suffix Gib ein Suffix an, das an das Ende jeder Eingabeaufforderung angehängt wird. /relax Wechselt in den Relax-Modus. /fast Wechselt in den Fast-Modus. /describe Beschreibt ein Bild in vier Alternativen. Hilfe & Informationen /docs Diesen Befehl kannst du im offiziellen Midjourney-Discord-Server verwenden, um einen Link zu den in diesem Benutzerhandbuch behandelten Themen zu generieren! Wenn du /docs eingibst, siehst du eine Liste mit allen verfügbaren Themen. /faq Auf dem offiziellen Midjourney Discord Server verwenden, um schnell einen Link zu den FAQs des Popual Prompt Craft Channels zu generieren. /help Zeigt Infos und Tipps über den Midjourney Bot. Dein Account /info Zeigt Informationen über Deinen Account – z.B. wieviel Rechenzeit du diesen Monat noch hast – und alle anstehenden oder laufenden Aufträge an. /subscribe Erzeugt einen persönlichen Link zu deinem Account, um dein Abo einzusehen oder zu bearbeiten. Hier ist die vollständige Liste von Midjourney Befehlen (auf englisch)

-

Welche Parameter kann ich in meinem Midjourney Prompt nutzen?

Prompts sind deine Vorgaben, aus denen Midjourney Bilder generiert. Wie sie sich aufbauen, ist eine Kunst für sich, auf die wir in Tutorials und Beispielen eingehen werden. Sie setzen sich zusammen aus der detaillierte Beschreibung des Objekts, den Stil, die Lichtstimmung und z.B. Kamera und Objektiv, die simuliert werden sollen. Midjourney erlaubt es, ans Ende dieses Prompts noch einige Parameter anzuhängen, mit der die Ausgabe gesteuert wird. Wichtig ist dabei die Schreibweise: Hinter dem doppelten Bindestrich muss ohne Leerzeichen der Befehl kommen, wenn Werte genutzt werden, müssen sie aber durch ein Leerzeichen getrennt werden. Hier haben wir die wichtigsten Midjourney aufgeführt, die eine deutliche Wirkung auf das generierte Bild haben: Version Die neueste Version von Midjourney ist Version 5, aber auch ältere Versionen lassen sich nutzen. Einige Nutzer finden die letzte Version 4 kreativer. Für Experimente kannst du z.B., --v 4 anhängen, für die Version sind alle Werte zwischen 1 und 5 erlaubt. Aktuell (22. März 2023) kann Version 5 nur von zahlenden Kunden genutzt werden. Syntax: --v [Version] Seitenverhältnis Das Seitenverhältnis, auf englisch Aspect Ratio wird über den Parameter --ar gesteuert. z.B. --ar 3:2 erzeugt ein Querformat wie im 36x24 mm Format Alternativen sind 16:9 oder seit neuestem auch sehr extreme Seitenverhältnisse Wird nichts angegeben, wird immer ein quadratisches Bild im Seitenverhältnis 1:1 erzeugt. Die Abmessungen betragen dann 1.024 x 1.024 Pixel Syntax: --ar [Seitenverhältnis] Chaos Der Parameter --chaos definiert, wie unterschiedlich die Ergebnisse ausfallen sollen und wie viele Abweichungen in das Bild gerechnet werden sollen Syntax: --chaos [Zahl zwischen 0 und 100] Stilisieren Der Parameter --stylize definiert, wie stark Midjourneys ästhetischer Standardstil angewandt wird. Aktuell hat dieser Parameter in Version 5 keinen Einfluss, Es bleibt die Frage, ob das so bleibt. Syntax: --s [Zahl zwischen 0 und 1000] Ausschluss / Negativ-Prompt Wenn ihr bestimmte Elemente ausdrücklich nicht im Bild haben wollt, könnt ihr mit --no einen negativen Prompt mitgeben. Das Anhängsel --no plant schließt z.B. Pflanzen aus. Typische Anwendung ist --no text, um keine Buchstaben im Bild zu haben. Syntax: --no [unerwünschte Inhalte] Qualität Über den Parameter --q soll sich die Bildqualität steuern lassen. Je höher der Wert ist, desto besser soll die Qualität sein – es wird aber auch mehr Rechenzeit benötigt. Wichtig: Es wird die Bildqualität gesteigert, nicht jedoch die Auflösung. Syntax: --q [.25, .5, 1 oder 2]

-

Feedback zum AI Imagelab

Danke! Sehr guter Hinweis! Ich verfasse heute noch etwas wie „Über AI Imagelab“ und/oder „Erste Schritte“. FAQs gerne bei den jeweiligen Produkten eintragen und „FAQ“ in den Titel nehmen, alternativ als Tag nutzen. Ich bin sowieso dabei, Content aus dem Systemkamera Forum zu übernehmen, da kann ich das zeigen. Definitiv. Mittelfristig jedenfalls… Die nächsten Monate hat das AI Imagelab erstmal „Welpenschutz“, aber langfristig ist das natürlich ein kommerzielles Projekt (wie meine anderen Foren auch). Wenn Du Ideen oder Anregungen hast, gerne her damit – auch per Mail oder PN. Ich würde es gerne bei „Bilder“ belassen, weil einfacher zu verstehen. Auf jeden Fall, immer gerne mehr davon! Gruß Andreas

-

[JeKaMi] Portraits mit Leonardo.AI

Wow, sehr cool… Leonardo.AI habe ich mir bisher noch nicht genauer angeschaut – aber das sollte ich wohl mal tun… Andreas

-

Welches Ergebnis könnt ihr mit KI Bilder nicht erreichen

Ich bin unsicher, ob man das mit Midjourney hinbekommen kann – da bin ich aber nicht der große Experte. Hat @adrianrohnfelder vielleicht eine Idee?

-

Adobe Ankündigung: Adobe Firefly für Video

Adobe hält weiter Druck auf dem Kessel: Nach der Beta-Version von Adobe Firefly, um statische Inhalte zu generieren, präsentiert der Software-Hersteller jetzt eine Vision, wie Adobe Firefly für Video als kreativer Co-Pilot „ihre Entdeckungs- und Ideenfindungsprozesse beschleunigen und die Postproduktionszeit von Tagen auf Minuten reduzieren“ können. Hier die Pressemitteilung: Adobe Firefly bringt generative KI in die Creative Cloud In den vergangenen zehn Jahren hat Adobe mit Adobe Sensei, Adobes Framework für künstliche Intelligenz und maschinelles Lernen, hunderte von KI-gestützten Funktionen bereitgestellt. Tools wie Auto Reframe und Remix in Premiere Pro und Inhaltsbasierte Füllung in After Effects helfen Video- und Audioprofis auf der ganzen Welt bereits dabei, in einem Bruchteil der Zeit beeindruckende Inhalte zu erstellen. Wir betreten damit eine neue Ära, in der generative KI eine natürliche Konversation zwischen Kreativen und Computer ermöglicht und in der die Eingabe eigener Worte und einfacher Gesten mit den besten Workflows professioneller Kreativanwendungen kombiniert werden, um einen neuen kreativen Workflow zu ermöglichen. Letzten Monat hat Adobe Firefly angekündigt, die neue Produktfamilie kreativer generativer KI-Modelle und die nächste große Evolutionsstufe der KI-gesteuerten Kreativität und Produktivität. Das erste Modell, das mit Bilderzeugung und Texteffekten beginnt, wurde mit Adobe Stock-Bildern, offen lizenzierten Inhalten und Public Domain-Inhalten, deren Urheberrecht abgelaufen ist, trainiert und ist darauf ausgelegt, Inhalte zu generieren, die für die kommerzielle Nutzung sicher sind. Firefly ist jetzt als Beta-Version verfügbar und es wurden bereits Konzepte vorgestellt, wie Firefly in naher Zukunft in Photoshop, Illustrator und andere Adobe-Anwendungen eingebettet werden könnte. Auf der NAB erweitert Adobe seine Vision für Firefly bereits und präsentiert Möglichkeiten, wie die Funktionen von Firefly in die Video- und Audioanwendungen von Adobe integriert werden können. Adobe Firefly für Video – eine Vision Wir befinden uns wahrlich im goldenen Zeitalter des Videos. Kurzvideos sind in Nachrichten, sozialen Medien und Unterhaltung allgegenwärtig. Die extreme Nachfrage, die Vielzahl der Kanäle und die dezentralen Teams machen es besonders schwierig, die Produktion hochwertiger kreativer Arbeiten effizient zu gestalten. Aus diesem Grund ist Adobe bestrebt, gemeinsam mit der Video- und Audio-Community Innovationen zu entwickeln, um Visionen einfacher und schneller in Realität zu verwandeln. Mit Firefly als kreativem Co-Piloten können Kreative ihre Entdeckungs- und Ideenfindungsprozesse beschleunigen und die Postproduktionszeit von Tagen auf Minuten reduzieren. Direkt in die Workflows integriert, werden diese leistungsstarken neuen Funktionen den Nutzer*innen jederzeit zur Verfügung stehen. Mit Firefly werden Nutzer*innen unmittelbar die Tageszeit eines Videos ändern, automatisch relevante B-Rolls finden oder unbegrenzte Variationen von Clips erstellen können – alles als Ausgangspunkt für ihre Kreativität. Aktuell erforscht Adobe eine Reihe von Ansätzen: Text zu Farbverbesserungen: Farben, Tageszeiten oder sogar Jahreszeiten können in bereits aufgenommenen Videos geändert werden, um eine bestimmte Stimmung zu erzeugen. Text-zu-Video-Eingaben ermöglichen es, dass mit einer einfachen Aufforderung wie „diese Szene soll warm und aufregend wirken" der Zeitaufwand zwischen Idee und finalem Produkt fast verschwindet. Erweiterte Musik- und Soundeffekte: Mit Hilfe von Textanweisungen können Nutzer*innen benutzerdefinierte lizenzfreie Klänge und Musik erzeugen, die zu einer bestimmten Stimmung und Szene passen, entweder als temporäre oder endgültige Tracks. Beeindruckende Schriftarten, Texteffekte, Grafiken und Logos: In wenigen Minuten können mithilfe einfacher Formulierungen Untertitel, Logos und Titelkarten mit benutzerdefinierten Animationen erstellt werden, die auf den Präferenzen der Ersteller*innen basieren. Leistungsstarke Skript- und B-Roll-Funktionen: Firefly beschleunigt die Arbeitsabläufe in der Vorproduktion, der Produktion und der Postproduktion erheblich, indem es KI-Analysen von Drehbuchtexten nutzt, um automatisch Storyboards und Vorvisualisierungen zu erstellen und B-Roll-Clips für Roh- oder Endschnitte zu empfehlen. Creative Guide-Funktionen: Mit Hilfe von personalisierten mit generativen KI-gestützten Anleitungen können Anwender*innen neue Fähigkeiten erlernen und Prozesse von der ersten Vision bis zur Erstellung und Bearbeitung beschleunigen.

-

Feedback zum AI Imagelab

Ich richte diese Diskussion ein, damit ihr uns Feedback zur neuen Community geben könnt: Funktioniert alles wie erwartet? Ist die Struktur sinnvoll oder fehlt für dich was? Freue mich über eure Kritik und Rückmeldungen, damit wir hier schnell eine große und aktive Community an den Start bekommen! Andreas

-

Welches Ergebnis könnt ihr mit KI Bilder nicht erreichen

Hast du mal Beispiele? Vielleicht können wir gemeinsam experimentieren…

-

Tipp: Adobe Firefly Beta „Zugangsanforderung“ E-Mail Adresse

Wie lange hat das bei euch gedauert? Habe mich zweimal angemeldet – einmal vor drei, einmal vor einer Woche – , bekomme aber keinen Zugang. Gruß Andreas

-

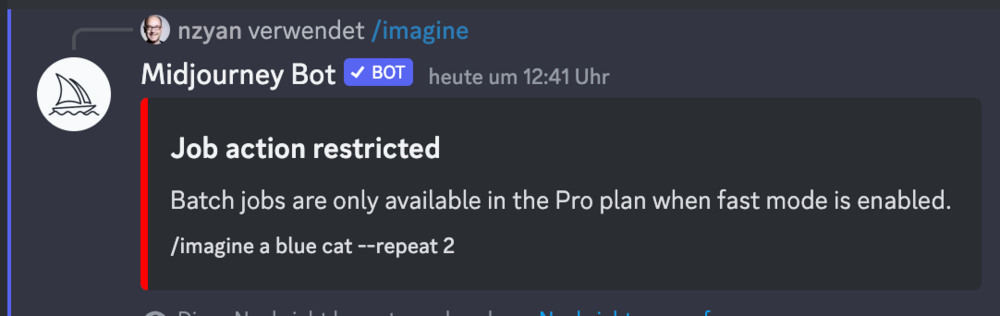

[Update] Zwei neue Midjourney Optionen: Repeat und Permutationen

Midjourney stellt zwei neue Funktionen vor, mit denen sich einfacher zusätzliche Variationen eines Bildes generieren lassen: Repeat und Permutationen Wie sie funktionieren, erkläre ich gleich – vorweg der Haken an der Sache: Diese Funktionen stehen nur für die teuerste Bezahlvariante (PRO für 60$ im Monat) zur Verfügung, da sie Unmengen an Prozessorleistung verschlingen. [Update 10. April 2023]: Bis zu 10 Wiederholungen sind jetzt auch mit dem Standard-Account (30$ / monat) möglich! Einführung Repeat-Funktion An das Ende eines Prompts musst du --repeat mit einer Zahl eingeben, um den so oft wie angegeben auszuführen Zum Beispiel erzeugt /imagine cats --repeat 5 fünf 2x2 Raster mit Katzen. Am besten mit Parameter wie --chaos kombinieren, um eine möglichst große Variationsbreite zu bekommen. Einführung in Permutationen Mit dieser Funktion kannst du eine große Anzahl von Jobs mit verschiedenen Wortkombinationen in einem Rutsch definieren. Ein einfaches Beispiel für Permutationen: /imagine a {cyberpunk, vaporwave, art deco} (cat, dog) Im Prompt werden alle drei Elemente der ersten Liste mit den zwei Elementen der zweiten kombiniert. Dies erzeugt 2 x 3 also sechs Jobs: /imagine a cyberpunk cat /imagine a vaporwave cat /imagine a art deco cat /imagine a cyberpunk dog /imagine a vaporwave dog /imagine a art deco dog Man kann sogar {} in anderen {} verschachteln – aber Vorsicht, das kann schnell in extrem viele Aufträge eskalieren… /imagine A {sculpture, painting} of a {seagull {on a pier, on a beach}, poodle {on a sofa, in a truck}}.

-

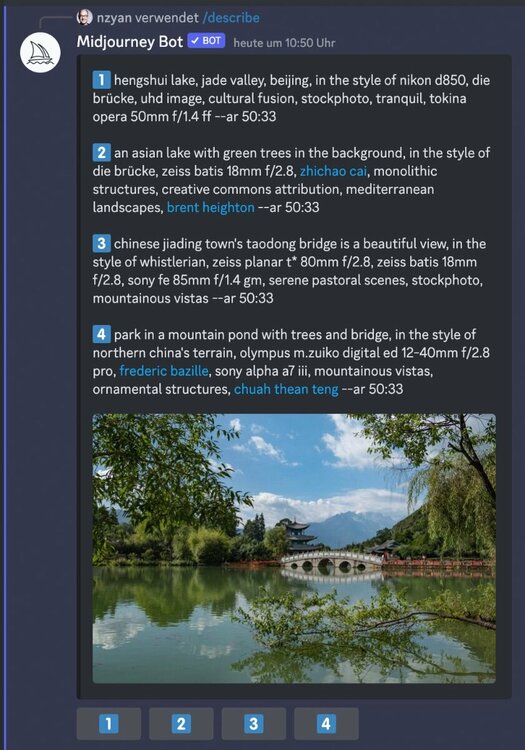

Neuer Midjourney Befehl „/describe“

Hier ein Beispiel: Aus dem Bild einer chinesischen Parkkulisse (echtes Foto, wirklich) hat Midjourney vier verschiedene Beschreibungen generiert, von der wiederum eine als Prompt für die neuen Bilder genutzt wurde:

-

Neuer Midjourney Befehl „/describe“

Seit kurzem hat Midjourney einen neuen Befehl, der den bisherigen Weg umdreht: Mittels /describe wird aus Text-to-Image Image-to-Text – Midjourney liefert zu hochgeladenen Bildern eine Beschreibung. Heute Nacht wurde per Twitter die Funktion angekündigt: Die Funktion ist noch so neu, dass sie in der Dokumentation der Midjourney Befehle nicht aufgeführt ist (Stand 4. April 2023). Zudem scheint sie noch im Beta-Stadium zu sein, da der Befehl aktuell zuverlässig Fehlermeldungen generiert. Für sich genommen hat das einen begrenzten Nutzwert, aber es ergeben sich dadurch neue Möglichkeiten. Aus bestehenden Bildern lassen sich Prompt-Vorlagen für neue Bilder generieren Für Bilder im Web lassen sich Alternativ-Texte generieren, die für Menschen mit Sehbehinderung eine enorme Erleichterung darstellen

_055d65.png)

_ee1da0.png)