Es wird immer schwieriger, „echte“ Bilder von KI-Bildern zu unterscheiden. Dagegen wird es immer einfacher mit wenigen Schritten überzeugende „Deep Fakes“ zu erzeugen, die zumindest auf den ersten Blick nicht mehr von realen Bildern zu unterscheiden sind.

Wir haben uns Tools angeschaut, die versprechen KI Bilder und damit auch Deep Fakes zuverlässig zu erkennen. Die Ergebnisse waren eher enttäuschend, daher werfen wir auch einen Blick auf die Alternativen.

Inhalte

Erkennung von Deep Fakes

Um KI Bilder automatisiert zu identifizieren, gibt es einige Ansätze, z.B. die Analyse des Bildrauschens, eingebettete Meta-Daten oder andere Marker in den Daten. Es ist aber aus mehreren Gründen extrem unwahrscheinlich, dass sich hier eine dauerhafte Lösung etablieren wird:

- Die Technologie der generativen KI entwickelt sich zu rasant. Merkmale von KI Bildern, die heute noch relevant sind, können morgen schon obsolet sein. Entsprechende Analyse Tools werden immer hinterher hinken und werden finanziell nicht gefördert.

- Sobald ein Diagnose-Verfahren zuverlässig Deep Fakes identifiziert, werden die Übeltäter schnell die entsprechenden Marker finden und diese gezielt verschleiern.

Das Ergebnis ist ein Katz-und-Maus-Spiel, in dem Betrüger und böswillige Akteure immer die größeren finanziellen Ressourcen haben werden. Plattformbetreiber wie Meta (Instagram, WhatsApp und Facebook) oder Elon Musks X haben ebenfalls kein gesteigertes Interesse an einem KI Filter, der Geld und Personal erfordert. Schon jetzt werden sehr offensichtliche Betrugsversuche nicht aktiv verfolgt, die weder durch KI erzeugt noch schwierig zu identifizieren sind.

Tools zur Überprüfung auf Deep Fakes

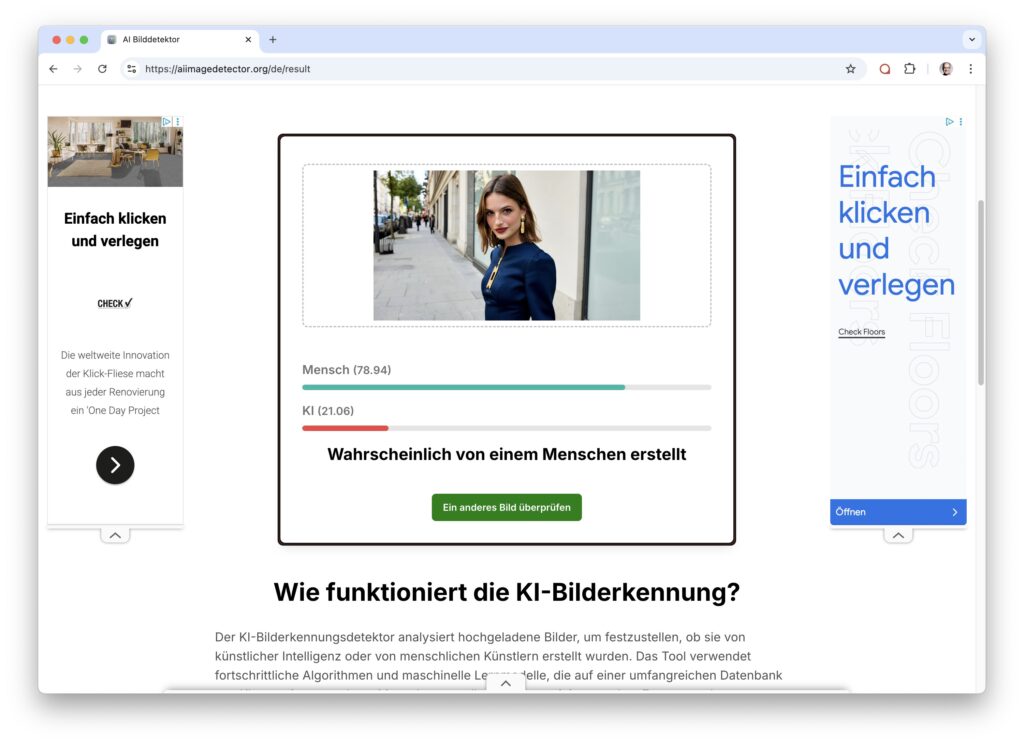

Trotz der Schwierigkeiten, geeignete Algorithmen zu finden, die dauerhaft KI Bilder identifizieren, werden zahlreiche Online Tools angeboten, mit denen man angeblich zielsicher KI Bilder identifizieren kann. Wir haben das mal getestet, indem wir online verfügbare Dienste mit einer Auswahl von KI-Bildern und echten Fotos konfrontiert haben.

Testdaten: Echte Bilder / KI Bilder

Als Testdaten haben Adrian und Andreas jeweils einen Satz von fotorealistischen KI generierten Bildern zusammengestellt, die mit Midjourney und Higgsfield generiert wurden. Als Gegenprobe dienen einige „garantiert echte“ Fotos aus Andreas’ Archiv, gemischt aus Smartphone und Fujifilm Kameras. Um die Qualität einer App zu beurteilen, ist es natürlich auch wichtig, dass sie KI Bilder ebenso erkennt wie echte Bilder aus Smartphone oder Digitalkamera.

Testdaten: Echte Fotos aus Smartphone und Systemkamera

Testdaten: KI Bilder aus Midjourney und Higgsfield

Diesen Pool aus 21 Bildern haben wir sechs verschiedenen Tools vorgesetzt, die online verfügbar sind. Es finden sich Netz deutlich mehr Angebote, von denen viele aber nicht richtig funktionieren oder vor dem ersten Test ein bezahltes Abo verlangen.

Alle Anwendungen geben für jedes Bild jeweils eine Prognose ab, in der Regel als prozentuale Wahrscheinlichkeit zwischen 0 und 100%, ob ein Bild KI-generiert ist.

Die Ergebnisse: Ernüchternd

Um die Prognosen miteinander zu vergleichen, haben wir ermittelt, wie dicht die Prognosen (z.B. „mit 33% Wahrscheinlichkeit KI-generiert“) an der Realität (100% KI oder 100% echtes Foto) lagen. Die Ergebnisse waren gemischt und größtenteils ernüchternd, nur zwei von sechs Anwendungen erkennen KI Bilder deutlich besser als ein Zufallsgenerator.

Zwei Tools schaffen es sogar schlechter als der Zufall z usein: Hätten sie willkürlich geraten, hätten sie rein statistisch betrachtet ein besseres Ergebnis erzielt.

- Illuminarty bildet das Schlusslicht: Reale Bilder wurden zwar erkannt, von 15 KI Bildern wurde nur eins sicher (80%) und eins mit geringer Wahrscheinlichkeit (53%) erkannt.

- Der IMGDetector scheint eher eine Art Zufallsgenerator zu sein und erzeugt überwiegend uneindeutige und pseudogenaue Ergebnisse (54,5 % / 45,5 %), sowohl für echte wie für KI Bilder.

Ebenfalls zwei Tools erzielten ca. 60% Trefferquote: Echte Bilder wurden gut erkannt, aber nur etwas mehr als die Hälfte der KI-Bilder.

- We detect erkennt sehr gut echte Fotos, versagt aber mit einer Trefferquote von 45% bei KI Bildern.

- Etwas besser ist Hive Moderation, die ebenfalls echte Bilder gut erkennt, aber nur 48% Trefferquote bei KI Bildern hat.

Zwei Angebote können wir nach unserem Kurztest zumindest eingeschränkt empfehlen:

- Undetectable erkannte alle echten Fotos korrekt, hielt aber auch vier von 15 KI-Bildern für reale Bilder.

- Testsieger ISGen AI Image Detector erkannte 100% der echten Fotos mit großer Sicherheit und hielt aber drei KI-Bilder für echt. Alle Midjourney Bilder wurden mit einer 100% Sicherheit erkannt, nur bei Adrians Higgsfield Bildern lag sie dreimal daneben.

Interessantes Detail: Es waren unterschiedliche Bilder, die von den beiden Tools nicht erkannt wurden. Insofern scheinen sie mit unterschiedlichen Algorithmen und Markern zu arbeiten.

Die Ergebnisse im Überblick

| Echte Fotos | KI Bilder | Gesamtnote | ||

| ISGen | 100,0 % | 81,9 % | 87,0 % | 🟩 |

| Undetectable | 99,0 % | 71,8 % | 79,6 % | 🟩 |

| Hive Moderation | 98,3 % | 47,8 % | 62,2 % | 🟨 |

| We detect | 98,3 % | 45,7 % | 60,7 % | 🟨 |

| IMGDetector | 44,0 % | 48,4 % | 47,2 % | 🟥 |

| Illuminarty | 92,2 % | 21,1 % | 41,5 % | 🟥 |

Abschlussnote Ungenügend

Zumindest die getesteten Analyse Tools sind nicht geeignet, um KI Bilder zuerlässig zu identifizieren. Sogar die Trefferquote der besten App von 80% ist nicht berauschend. Noch nicht berücksichtigt sind dabei die bereits oben genannten Faktoren: Die rasante technische Entwicklung und aktive Verschleierung von Deep Fakes.

Schutz vor Deep Fakes: Die Alternativen

Was bleibt als Alternative, um Deepfakes zu erkennen?

Als technische Lösung bleibt die Umkehrung des Nachweises: Nicht KI Bilder werden als solche erkannt, sondern umgekehrt weisen echte Bildern durch digitale Zertifikate ihre genaue Herkunft nach, konkret durch CAI Content Credentials. Damit sich diese Lösung durchsetzt, müssen einige Hürden genommen werden:

- Für einen lückenlosen Nachweis der Herkunft müssen Kameras, Bildbearbeitungs-Software, Redaktionssysteme und Veröffentlichungsplattformen diesen Standard technisch unterstützen.

- Alle Beteiligten müssen den Prozess diszipliniert einsetzen. Ist die Nachweiskette an einer Stelle unterbrochen, ist der Nachweis wertlos.

- Nicht zuletzt müssen die Medienkonsumenten das Zertifikat für zuverlässig und vertrauenswürdig halten.

Erst wenn all diese Voraussetzungen erfüllt sind, haben die Content Credentials eine Chance, sich langfristig als zuverlässiger Nachweis für die Herkunft digitaler Bilder zu etablieren

Fokus Medienkompetenz

Es ist naheliegend, Probleme mit einer Technologie auf einem technischen Weg (automatische Erkennung, Zertifizierung) zu lösen. Dies wird aber immer ungenügend bleiben, wenn die Flut gefälschter Bilder auf schlecht informierte Bürger trifft. Jedes Vorgehen gegen Deep Fakes sollte mit einschließen, die viel beschworene Medienkompetenz zu steigern. Für KI Bilder heißt dies aktuell:

Traue keinem Bild mehr – vor allem, wenn du die Herkunft nicht nachvollziehen kannst.

Mit dieser Einstellung kann man sich die Bilder genauer anschauen. Die erste Frage sollte dabei immer sein: Kann das wirklich sein? Bilder von Drachen oder Politikern in Superheldenkostümen (oder Sträflingskleidung) sollten für Skepsis sorgen – und nicht als Beleg für Verschwörungstheorien dienen.

Nach einem ersten Plausibilitäts-Check kann man sich dann das Bild genauer anschauen und anatomische Details, Schattenwürfe, Fluchtpunkte. Darstellung von Schrift und die Einhaltung physikalischer Gesetze überprüfen. Aktuell fehlt die KI Modellen noch die Fähigkeit, Szenarien abzubilden, in denen physikalische Gesetze z.B. von Schwerkraft und Optik aktiv berücksichtigt werden.

Und: Lassen sich KI-Bilder und Deep Fakes sicher erkennen?

Zumindest zum jetzigen Stand lassen sich viele Deep Fakes noch erkennen, wenn man sich mit einem gesunden Misstrauen und etwas Hintergrundwissen auf die Suche macht. Technische Aspekte können bei der Analyse helfen, die angebotenen Online Tools taugen aber nicht für sichere Prognosen.

Zuverlässige Aussagen wird es nur umgekehrt für den Nachweis echter Fotografien geben, ob sich dies am Markt durchsetzt, bleibt abzuwarten.

Unsere Empfehlung ist leider etwas fatalistisch: Es wird immer schwieriger KI-Bilder sicher von echten Bildern zu unterscheiden. Dies durch juristische Vorgaben oder technische Mittel einzufangen, wird nicht möglich sein. Wir werden uns damit abfinden müssen, dass jedes Bild KI-generiert sein kann, bis zum Nachweis des Gegenteils. Die Content Credentials können als Nachweis für echte Bilder dienen – der umgekehrte Nachweis wird über kurz oder lang nicht mehr möglich sein.

Sollen wir dich über die weiteren Entwicklungen auf dem Laufenden halten? Abonnieren unseren Newsletter!